Az AI forradalmasítja a social engineering támadásokat - mit tehetünk ellene?

Az EU AI Act korlátozásai vs. hatékony védekezés. Már most kijelenthetjük: ez így nem lesz jó. Az Európai Unió “agyonszabályozza” az új technológiák használatát és rendre lemarad a versenyben.

A kiberbűnözés világában új korszak köszöntött be: az AI-alapú social engineering támadások korábban nem látott kihívások elé állítják a vállalatokat és felhasználókat egyaránt. A technológia fejlődésével a csalók eszköztára is jelentősen bővült, ami miatt újra kell gondolnunk a védekezési stratégiáinkat.

A modern social engineering három pillére

A támadások három fő területen váltak különösen kifinomulttá:

Deepfake videók: A számítógéppel generált arcok és hangok már annyira élethűek, hogy videokonferencia-hívásokon keresztül képesek megtéveszteni még a tapasztalt szakembereket is.

Hangklónozás: Néhány másodpercnyi hangminta elegendő ahhoz, hogy a csalók tökéletesen lemásolják valaki hangját, amit aztán zsarolásra vagy csalásra használnak.

AI-vezérelt adathalászat: Az automatizált, mégis személyre szabott támadások költséghatékonyan és nagy skálán kivitelezhetők, miközben a sikerességi rátájuk is javul.

Miért különösen veszélyesek az AI-alapú támadások?

Az új típusú támadások azért jelentenek különös kockázatot, mert:

Rendkívül meggyőzőek és nehezen felismerhetők

Kihasználják az emberi természet alapvető tulajdonságait (bizalom, tekintélytisztelet, félelem)

Nagy léptékben, mégis személyre szabottan kivitelezhetők

A hagyományos védekezési módszerek kevésbé hatékonyak ellenük

Hogyan védekezzünk?

A védekezés többrétű megközelítést igényel:

Gyakorlati képzések: A munkavállalóknak valósághű, szimulált támadásokon keresztül kell megtapasztalniuk a veszélyhelyzeteket

Folyamatos éberség: A "Soha ne bízz, mindig ellenőrizz" elv következetes alkalmazása

Technológiai védelem: Modern biztonsági megoldások implementálása

Protokollok kialakítása: Világos eljárásrendek létrehozása különösen a pénzügyi tranzakciók területén

A legfontosabb üzenet: az AI-alapú social engineering ellen csak komplex megközelítéssel lehet védekezni. A technológiai védelem mellett kulcsfontosságú a humán faktor megerősítése, hiszen a támadók továbbra is az emberi gyengeségeket célozzák - csak most már fejlettebb eszközökkel.

AI-alapú védekezési módszerek

Az AI nem csak a támadók eszköztárát bővíti, hanem a védekezésben is fontos szerepet játszhat:

Viselkedés-elemzés: AI algoritmusok figyelhetik a felhasználók szokásos viselkedési mintáit, és jelezhetik a gyanús eltéréseket

Deepfake detektálás: Speciális AI modellek képesek felismerni a manipulált hang- és videótartalmakat

Intelligens email szűrés: Fejlett nyelvi modellek azonosíthatják a kifinomult adathalász kísérleteket, még ha azok személyre szabottak is

Valós idejű kommunikáció-ellenőrzés: AI rendszerek folyamatosan monitorozhatják a vállalati kommunikációt a social engineering támadások jelei után kutatva

Fontos megjegyezni, hogy az AI-alapú védekezés önmagában nem elegendő - ezt mindig emberi szakértelemmel és megfelelő biztonsági protokollokkal kell kombinálni.

Az EU AI Act korlátozásai vs. hatékony védekezés: Egyensúlykeresés

Az AI alapú kiberfenyegetések megjelenésével párhuzamosan az EU AI Act szigorúan szabályozza az AI rendszerek használatát, különösen a megfigyelés és viselkedéselemzés területén. Ez új megközelítést tesz szükségessé:

Eseményalapú detektálás: Tömeges megfigyelés helyett konkrét biztonsági incidensek azonosítása és elemzése

Korlátozott hatókörű védelem: Csak a kritikus vállalati rendszerek és folyamatok monitorozása, szigorúan meghatározott keretek között

Explicit hozzájárulás: A felhasználók tájékoztatása és beleegyezésük megszerzése minden AI-alapú védelmi megoldás esetén

A jogszerű védekezési stratégia elemei:

Előzetes adatvédelmi hatásvizsgálatok elvégzése

Minimális adatgyűjtés elvének alkalmazása

Alternatív, nem megfigyelés-alapú védelmi megoldások előtérbe helyezése

Rendszeres konzultáció adatvédelmi szakértőkkel és hatóságokkal

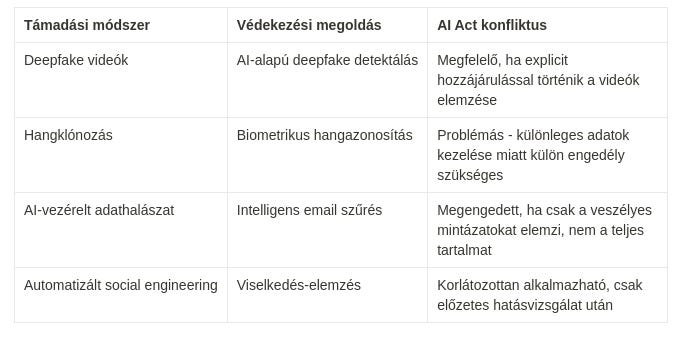

AI alapú támadások és védekezés az AI Act tükrében

Mindebből az következik, hogy az EU tagországaiban nem lehetséges modern, innovatív védekezés kialakítása, mivel a jelenlegi szabályozás alapján az alábbi megvalósítás lesz lehetséges:

EU jogszerű megközelítés

Rétegzett védelem: Több, kevésbé invazív módszer kombinálása a teljes megfigyelés helyett

Minimális adatgyűjtés: Csak a feltétlenül szükséges adatok elemzése, korlátozott ideig

Átláthatóság: A felhasználók részletes tájékoztatása az alkalmazott AI védelmi megoldásokról

Alternatív módszerek: Ahol lehetséges, AI-mentes védelmi megoldások előnyben részesítése

Kijelenthetjük, hogy ez így nem lesz jó. Az Európai Unió “agyonszabályozza” az új technológiák használatát és rendre lemarad az innovációban.

Konklúzió? Az nincs, csak “köldöknézés”

A hatékony védekezés és az új jogszabályi környezet közötti egyensúly megteremtése kritikus kihívás. A törvényhozóknak mélyebben meg kell érteniük a technológiai realitásokat, különben a szabályozás nem tud lépést tartani a fejlődő fenyegetésekkel. Az AI Act keretein belül is lehetséges eredményes védelmet kialakítani, de ehhez a jogalkotók és szakértők szoros együttműködése szükséges. A megoldás több pillérre épül:

A jogszabályoknak követniük kell a realitást, az új típusú kihívásokat

Jogszabályoknak megfelelő technológiai védelem implementálása

Adatvédelmi szempontból megfelelő biztonsági protokollok kialakítása

Felhasználók képzése az új típusú fenyegetések felismerésére

AI-alapú védelmi rendszerek szabályozott, transzparens alkalmazása

A kulcs a folyamatos párbeszéd és alkalmazkodás: ahogy fejlődnek a támadási módszerek és változik a szabályozási környezet, úgy kell finomhangolnunk mind a védelmi stratégiáinkat, mind a jogi keretrendszert - csak így tarthatunk lépést a kiberbűnözőkkel.